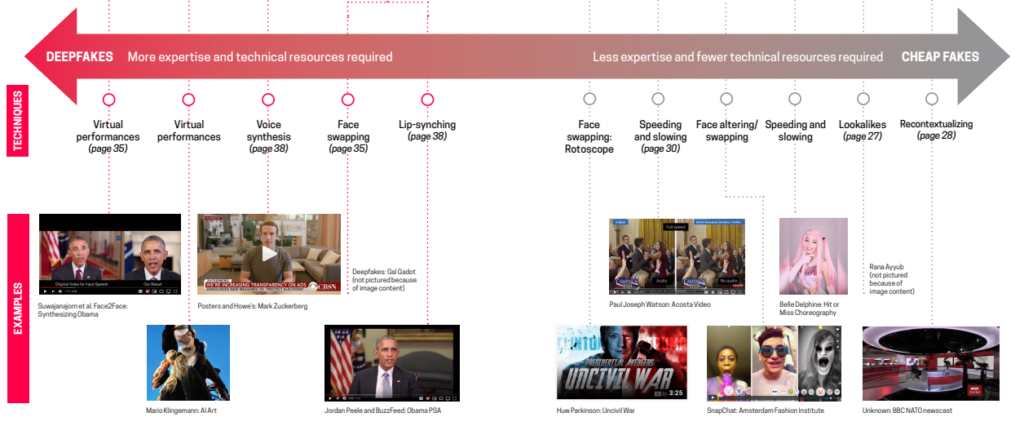

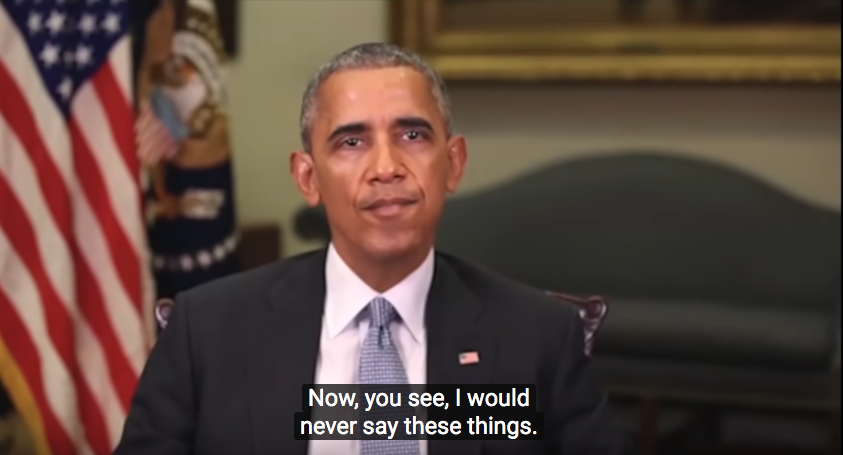

Un frame del deepfake di Obama creato da BuzzFeed News per mostrare le potenzialità di questa tecnologia.

A meno di un mese dal suo 16esimo compleanno, Facebook ha davanti sempre nuove sfide. La disinformazione (della quale ho parlato recentemente qui) e la tecnologia deepfake fanno sicuramente parte di questa lista. In un blog post dello scorso 6 gennaio Facebook ha annunciato di avere delineato, insieme a cinquanta esperti internazionali con vario background (tecnici, legali, accademici, media), alcuni criteri per la rimozione dei contenuti manipolati.

I contenuti di questo tipo dovranno rientrare nello specifico in due casistiche: a) contenuti modificati in modalità non comprensibile all’utente medio, che può effettivamente essere ingannato e portato a pensare che il soggetto di un video pronunci parole che in realtà non ha mai detto; b) i prodotti di intelligenza artificiale o di apprendimento automatico (machine learning) che uniscono, sostituiscono o sovrappongono contenuti a un video, facendolo sembrare autentico. Un simile discorso era stato intrapreso nel dicembre scorso anche da Instagram, social da tempo gemello di Facebook: ciò che è riscontrato falso sul primo sarà, se presente anche sul secondo, etichettato tale per entrambi.

Per quanto riguarda invece i video o i contenuti che non violano strettamente gli standard della community, Facebook opta per un approccio differente: non verranno rimossi bensì etichettati, ridotti nella loro importanza sul news feed e mantenuti sul social network proprio per lanciare un monito agli utenti e permettere un ragionamento critico sulla loro veridicità. In questo senso viene spiegato anche che in ogni caso quei contenuti sarebbero disponibili online su altri siti o social media, e quindi che sia più auspicabile contestualizzarli.

Nella mattinata di mercoledì 8 gennaio il gigante dei social, in audizione presso la House Committee on Energy & Commerce, ha anche confermato di non voler sottoporre a fact-checking le inserzioni politiche sponsorizzate. Come infatti riportato da Politico, Facebook permetterà agli utenti un livello di approfondimento maggiore sugli annunci legati alla politica ma non ha intenzione di limitare o controllare ciò che viene postato dai politici sulla piattaforma. Il portavoce dell’azienda, Tom Reynolds, nella stessa intervista, ha dichiarato che la posizione di Facebook al momento non cambierà, una posizione che, in vista delle presidenziali americane di novembre, non sembra un buon auspicio.

Le policy servono davvero?

È lecito domandarsi fino a che punto siano efficaci le regolamentazioni interne delle piattaforme. Le ultime azioni intraprese sono sicuramente rilevanti, anche se sembra che si continui a ignorare l’impatto di quello che in psicologia viene chiamato “confirmation bias” o “confirmatory bias”, ovvero un tipo di bias cognitivo che porta le persone a ricercare, interpretare, favorire o ricordare informazioni che in qualche modo possano avallare le loro credenze o ipotesi sul mondo.

Nel contesto digitale e nello specifico sui social media, questo errore di ragionamento viene amplificato per una serie di ragioni: facciamo tutti parte di una “filter bubble” (definito dall’attivista che ha coniato il termine, Eli Pariser, come personale ecosistema di informazioni che viene soddisfatto da alcuni algoritmi) determinata da algoritmi di profilazione del comportamento presenti quasi ovunque sul web e che ci sottopone contenuti condivisi da altri utenti con le nostre stesse convinzioni in merito a temi come la politica, lo sport, l’ambiente e così via. Per quanto il tema sia entrato nel discorso pubblico e nel linguaggio settoriale, l’effettiva esistenza delle filter bubble e il loro impatto sull’informazione dei cittadini è comunque discussa dalla ricerca accademica nel settore.

Ad ogni modo, gli utenti sono più predisposti a ricadere in questo tipo di errore cognitivo quando le informazioni che vengono sottoposte loro sono contenuti emozionali, o che rispecchiano valori o convinzioni molto radicate nell’individuo. Oltre a ciò, già negli anni ’80 è stato dimostrato come, anche se accuratamente screditate, informazioni o credenze false riuscissero in molti casi a rimanere radicate nell’individuo, anche rafforzandosi.

Questo tema, molto complesso, controverso e impossibile da sottovalutare in vista (anche) dei prossimi appuntamenti politici, è stato in parte oggetto di una nuova policy anche su Twitter proprio lo scorso anno. C’è chi esprime sfiducia nell’approccio che utilizzano i social network, soprattutto perché le modalità di individuazione dei contenuti manipolati sono complesse, non necessariamente efficaci, e i tempi lunghi: è possibile, infatti, che i contenuti etichettati come falsi o comunque attenzionati possano circolare molto prima di essere effettivamente controllati e accertati dalle piattaforme.

La questione controversa delle policy sta nel cercare di normare qualcosa che si è riscontrato nel comportamento degli utenti: indubbiamente utile, ma non è possibile fare esclusivamente un ragionamento di natura tecnologica. Il contesto, come detto, è fondamentale. Proprio per questo motivo non sono da sottovalutare gli spazi che Facebook, ad esempio, riconosce giustamente alla satira e alla parodia: molto spesso sono escamotage utilizzati per veicolare disinformazione, come nel caso del sito parodia di Joe Biden per le presidenziali 2020 o il recente articolo postato su un sito di satira chiamato Babylon Bee in merito alla morte del Generale Soleimani, condiviso più di 700.000 volte sulla piattaforma.

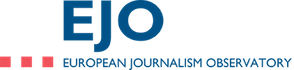

Deepfakes vs Cheap Fakes

C’è anche chi palesa dubbi e preoccupazioni maggiori in merito a contenuti molto meno elaborati e che sfuggono alla violazione degli standard della comunità dei social network, e quindi potenzialmente alle sue policy. Stiamo parlando dei cheap fakes, così chiamati da Britt Paris, Assistant Professor alla Rutgers University, e Joan Donovan, Diretrrice del Technology and Social Change Research Project all’Harvard Kennedy School, nel report “Deepfakes and Cheap Fakes. The Manipulation of Audio and Visual Evidence”, pubblicato da Data&Society.

Secondo le due ricercatrici, la manipolazione ottenuta attraverso machine learning o tecniche avanzate è solo una parte di ciò che in realtà popola i contenuti alterati online. Altre tecniche più economiche (cheap, nda) si basano infatti su più software accessibili oppure su nessun software. Contrariamente ai deepfake, che si basano su tecnologia molto più complessa.

Tra i software economici ci sono, ad esempio, Adobe After Effects e Premiere Pro (con i quali si possono realizzare discreti lavori di face swapping anche se non esperti), Sony Vegas Pro (per rallentare o velocizzare video), i filtri real time forniti gratuitamente da alcune applicazioni, effetti speciali della propria fotocamera (lookalikes), app che alterano la velocità dei video. Almeno la metà di questi sono in mano a qualsiasi ragazzo/a dagli 11 anni in su (o forse anche prima) poiché i nostri Play Store/App Store sono pieni di applicazioni come SnapChat, TikTok o anche la stessa Instagram, che possiamo utilizzare a questo scopo.

Questi strumenti sono al momento più accessibili, gratuiti e meno complessi da utilizzare per ottenere un risultato abbastanza buono o credibile. Al contrario, per creare un deepfake discreto, il reporter Timothy B. Lee di Ars Technica ha speso infatti 552 dollari e impiegato due settimane di lavoro. Un esempio efficace di cheap fake è invece quello recentemente riportato BuzzFeed News: una semplice storia di Instagram che ritrae alcune persone ballare, successivamente e deliberatamente associata alla campagna per le presidenziali 2020 di Mike Bloomberg.

È quindi importante tenere in considerazione che il contenuto, una volta ri-contestualizzato, tagliuzzato o velocizzato, non ha necessariamente bisogno di essere di alta qualità per essere credibile, almeno per quanto riguarda la politica. Infatti secondo il report 2019 di Deeptrace, azienda che si occupa di indagare il fenomeno deepfake, la quasi totalità dei contenuti video manipolati hanno come protagoniste donne ritratte in scene pornografiche. Anche se ancora non vi sono prove documentate di donne vittime di questa tecnologia in Europa, è chiaro come questi video siano per ora utilizzati maggiormente a sfondo sessuale o di harassment.

Anche Russell Brandom su The Verge mette in discussione la vera portata di questo fenomeno, forse ancora non arrivato al suo climax, ragionando sul fatto che la maggior parte delle persone ricade nel confirmation bias anche senza visionare un video manipolato con tecnologia deepfake. La più potente e accessibile forma di manipolazione audio video non è creata tecnicamente bensì appropriandosi del contesto: i tecnici forensi non troveranno un pixel fuori posto, ma solo storie false con ripercussioni reali.

Articolo apparso originariamente sul blog dell’autrice e ri-pubblicato, con modifiche, per gentile concessione. L’immagine a corredo di questo articolo è tratta da questo esperimento con i deepfake di BuzzFeed News.

Tags:deepfake, disinformazione, Facebook, manipolazione